ROC、AUC

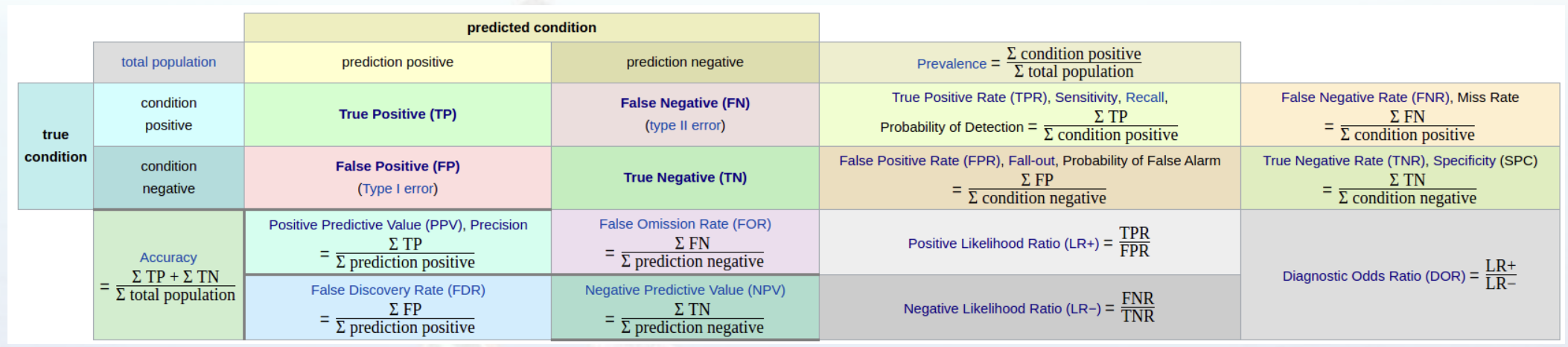

正确率(

Precision):真阳性率(True Positive Rate,

TPR),灵敏度(`Sensitivity),召回率(Recall):真阴性率(True Negative Rate,

TNR),特异度(Specificity):假阴性率(False Negatice Rate,

FNR),漏诊率(= 1 - 灵敏度):假阳性率(False Positice Rate,

FPR),误诊率(= 1 - 特异度):阳性似然比(

Positive Likelihood Ratio (LR+)):阴性似然比(

Negative Likelihood Ratio (LR-)):Youden指数(

Youden index):Youden index = Sensitivity + Specificity - 1 = TPR - FPR

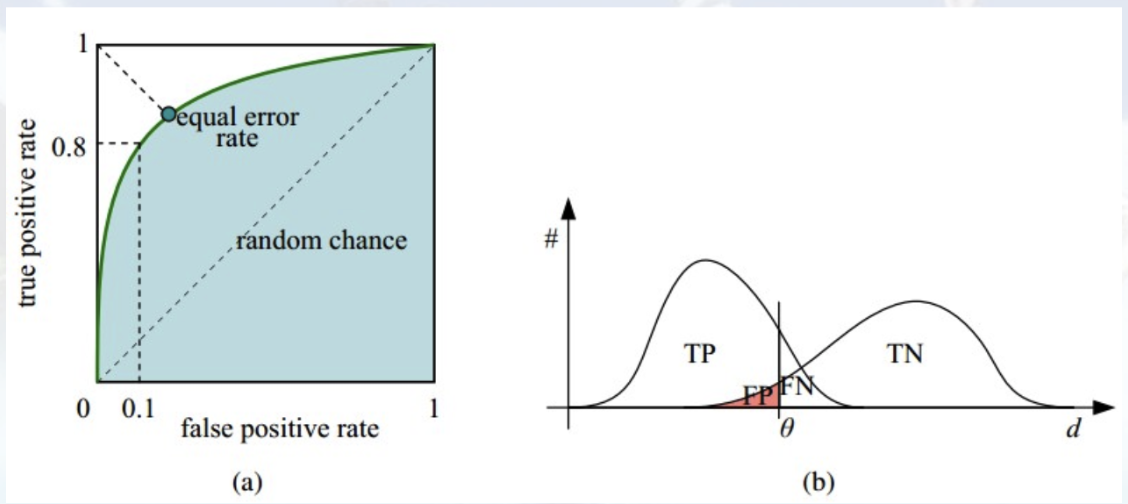

如下面这幅图,(a)图中实线为ROC曲线,线上每个点对应一个阈值

(a) 理想情况下,TPR应该接近1,FPR应该接近0。ROC曲线上的每一个点对应于一个threshold,对于一个分类器,每个threshold下会有一个TPR和FPR

比如threshold最大时,TP=FP=0,对应于原点;threshold最小时,TN=FN=0,对应于右上角的点(1, 1)

- 横轴FPR:1-TNR,1-Specificity,FPR越大,预测正类中实际负类越多

- 纵轴TPR:Sensitivity(正类覆盖率),TPR越大,预测正类中实际正类越多

- 理想目标:TPR=1,FPR=0,即图中(0, 1)点,故ROC曲线越靠拢(0, 1)点,越偏离45度对角线越好,Sensitivity、Specificity越大效果越好

(b) P和N得分不作为特征间距离d的一个函数,随着阈值theta增加,TP和FP都增加

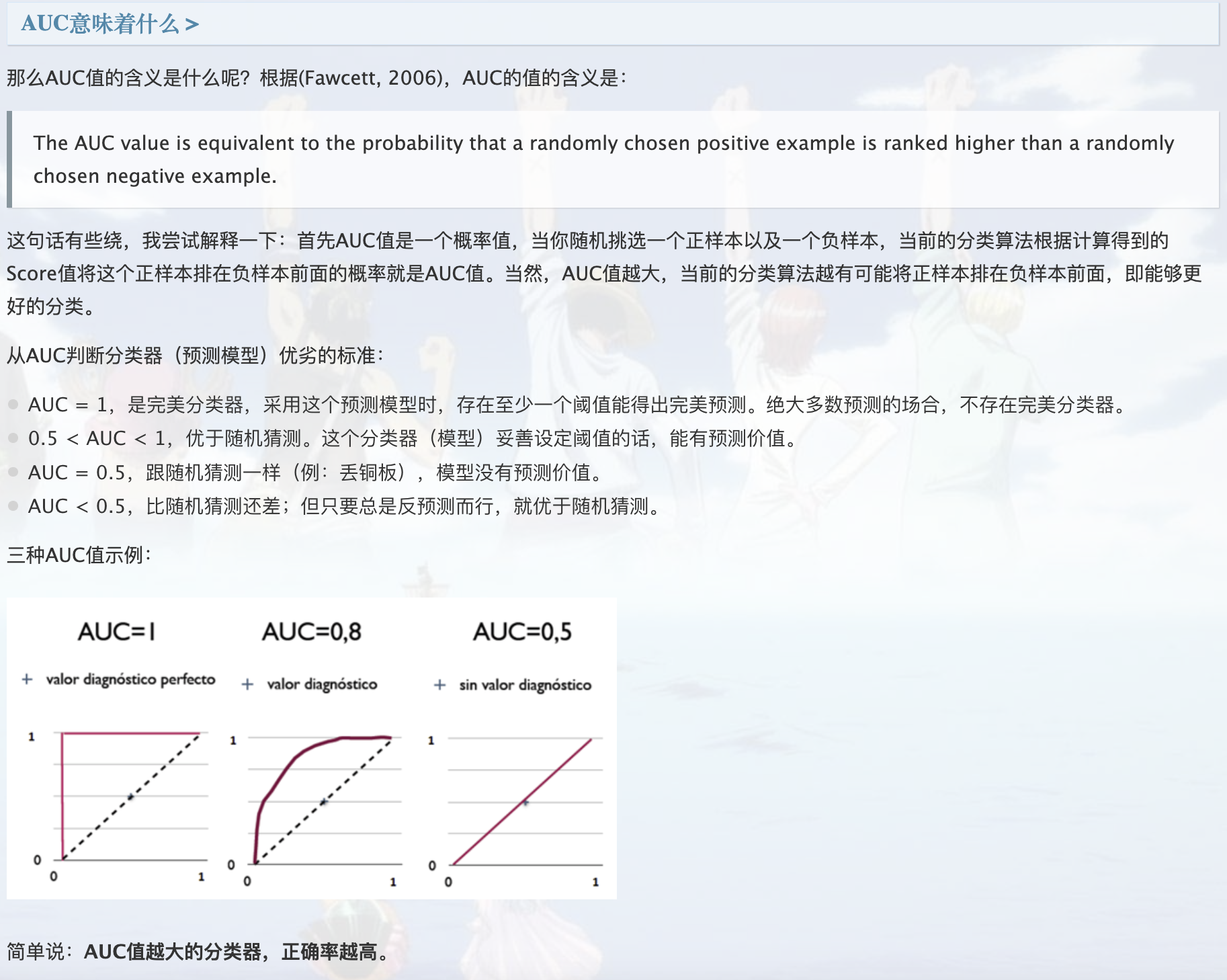

机器学习之分类性能度量指标 : ROC曲线、AUC值、正确率、召回率

模型评估指标AUC(area under the curve)_Webbley的博客-CSDN博客_auc指标

Delong’s test

比较AUC显著性差异

Delong test_liuqiang3的博客-CSDN博客_delong检验

McNemar’s test

如何计算McNemar检验,比较两种机器学习分类器 - 腾讯云开发者社区-腾讯云

C-index

Topic 13. 临床预测模型之一致性指数 (C-index)

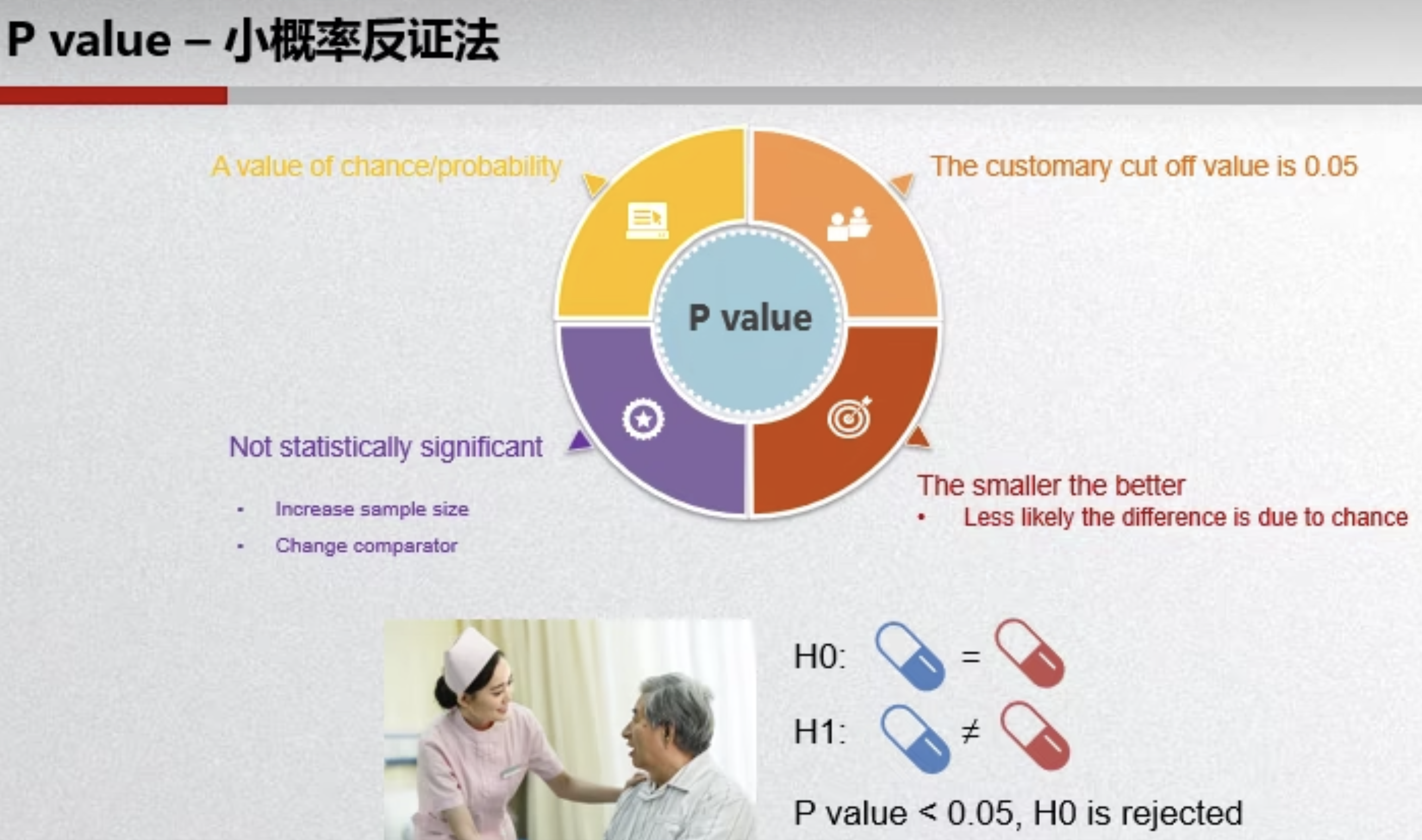

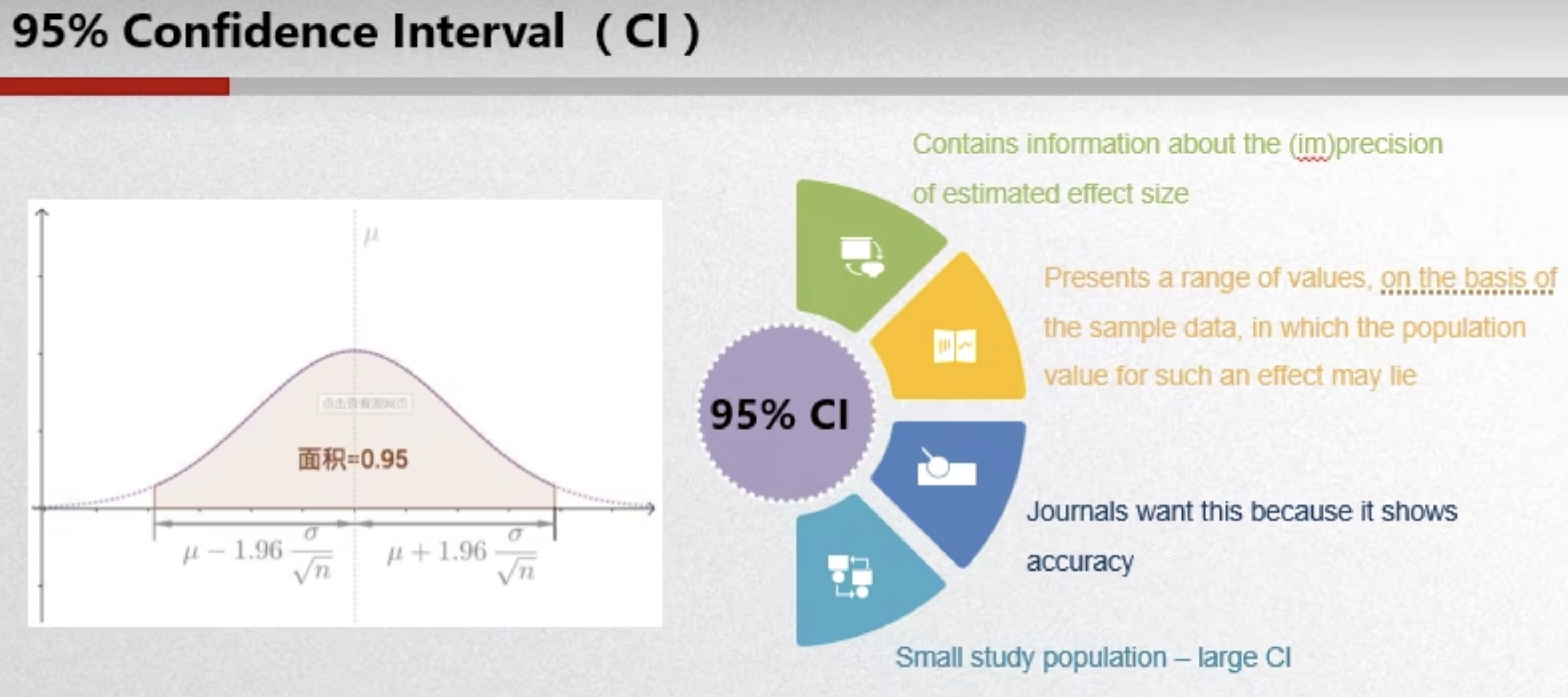

P-value、confidence interval

显著性检验:P值和置信度Chipei Kung的博客-CSDN博客显著性检验p值

灵敏度和特异度的置信区间怎么算?mjiansun的博客-CSDN博客敏感性置信区间

Non-inferiority

T-test

Kappa指数

Kappa系数简单介绍_gltangwq的博客-CSDN博客_kappa值